机器学习

机器学习(Machine Learning,ML)一门多领域交叉学科,涉及概率论、统计学、逼近学、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。

它是人工智能的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域,它主要使用归纳、综合不是演绎。

深度学习

深度学习是机器学习中一种基于对数据进行表征学习的方法。观测值(例如一幅图像)可以使用多种方式来表示,如每个像素强度值的向量,或者更抽象地表示成一系列边、特定形状的区域等。而使用某些特定的表示方法更容易从实例中学习任务(例如,人脸识别或面部表情识别)。深度学习的好处是用非监督式或半监督式的特征学习和分层特征提取高效算法来替代手工获取特征。

深度学习是机器学习研究中的一个新的领域,其动机在于建立、模拟人脑进行分析学习的神经网络,它模仿人脑的机制来解释数据,例如图像,声音和文本。

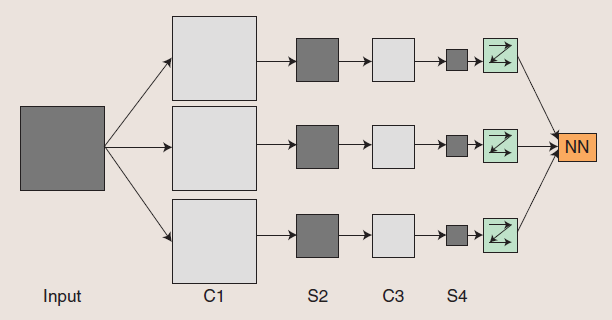

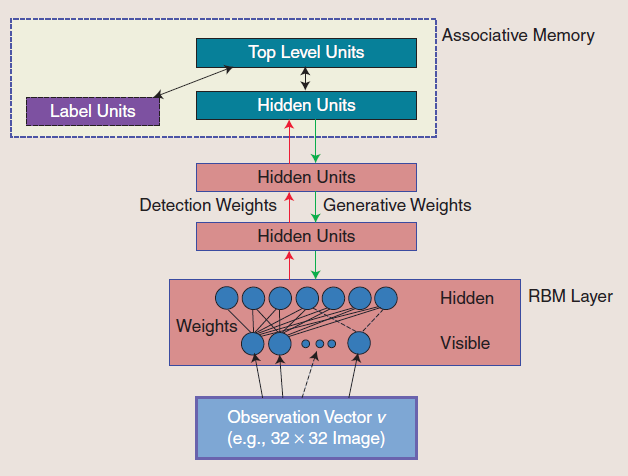

同机器学习方法一样,深度机器学习方法也有监督学习与无监督学习之分.不同的学习框架下建立的学习模型很是不同.例如,卷积神经网络(Convolutional neural networks,简称CNNs)就是一种深度的监督学习下的机器学习模型,而深度置信网(Deep Belief Nets,简称DBNs)就是一种无监督学习下的机器学习模型。

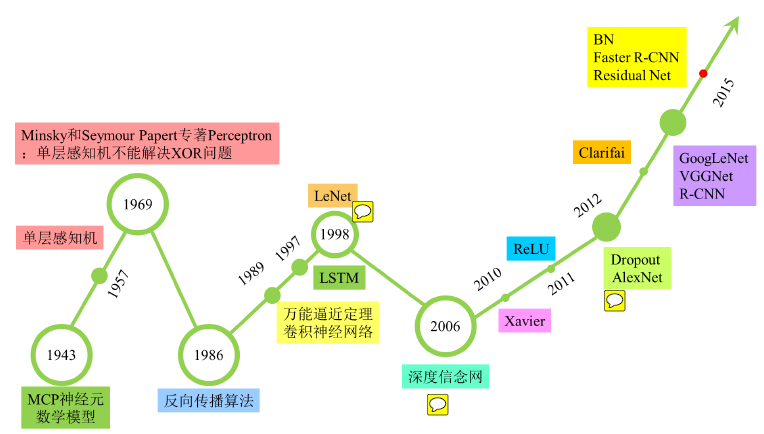

发展历史

由图可以明显看出DL在从06年崛起之前经历了两个低谷,这两个低谷也将神经网络的发展分为了三个不同的阶段。

第一代神经网络

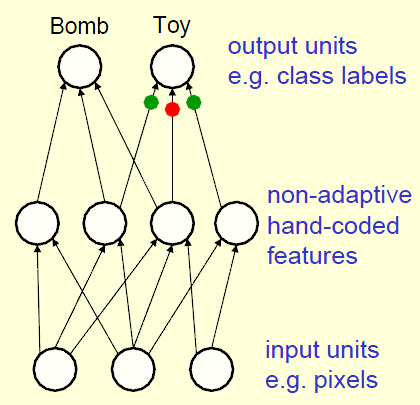

感知器(~1960)

感知器(Perceptrons)使用一层手编(Hand-coded)特征,通过学习如何给这些特征加权来识别对象。

感知器的优点:调整权值的学习算法很简洁。

感知器的缺点:感知器一些先天的缺陷,导致它们可以学习的东西大大地受限。

Vapnik和他的同事们发明了大名鼎鼎的支持向量机(SVM),改进了感知器的一些缺陷(例如创建灵活的特征而不是手编的非适应的特征),并得到了广泛的应用。但是归根到底,它还是一种感知器,所以无法避免感知器的先天限制。

第二代神经网络

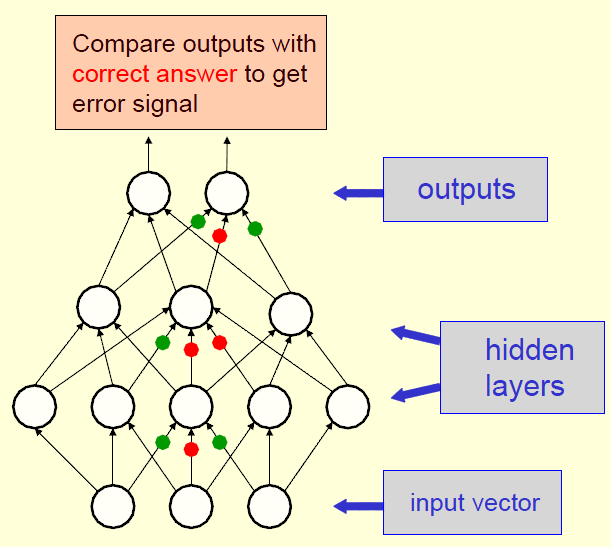

BP(反向传播,Back-propagate)神经网络(~1985)

BP神经网络通常使用梯度法来修正权值。BP并不是一种很实用的方法。原因有三:

- 它需要被标记的训练数据,但是几乎所有的数据都是未标记的。

- 学习时间不易衡量,在多层网络中,速度非常慢。

- 它陷入局部极小点而不收敛的情况极大。

第三代神经网络

最近的神经科学研究表明,和人类的许多认知能力相关的大脑皮层,并不显式地预处理感知信号,而是让它们通过一个复杂的模块层次结构,久而久之,就可以根据观察结果呈现的规律来表达它们。

这一发现促进了深机器学习(DML, Deep Machine Learning)的发展。DML关注的恰恰正是是信息表达的计算模型,和大脑皮层类似。

目前DML领域有两种主流的方法:

- 卷积神经网络

卷积神经网络

卷积神经网络 - 深度信念网络

深度信念网络

深度信念网络